L’organizzazione The Dawn Project ha analizzato diversi video su YouTube per rilevare quello che temeva fin dall’inizio: ovvero che il sistema di guida autonoma di Tesla non è sicuro. Per questo, ha chiesto un divieto.

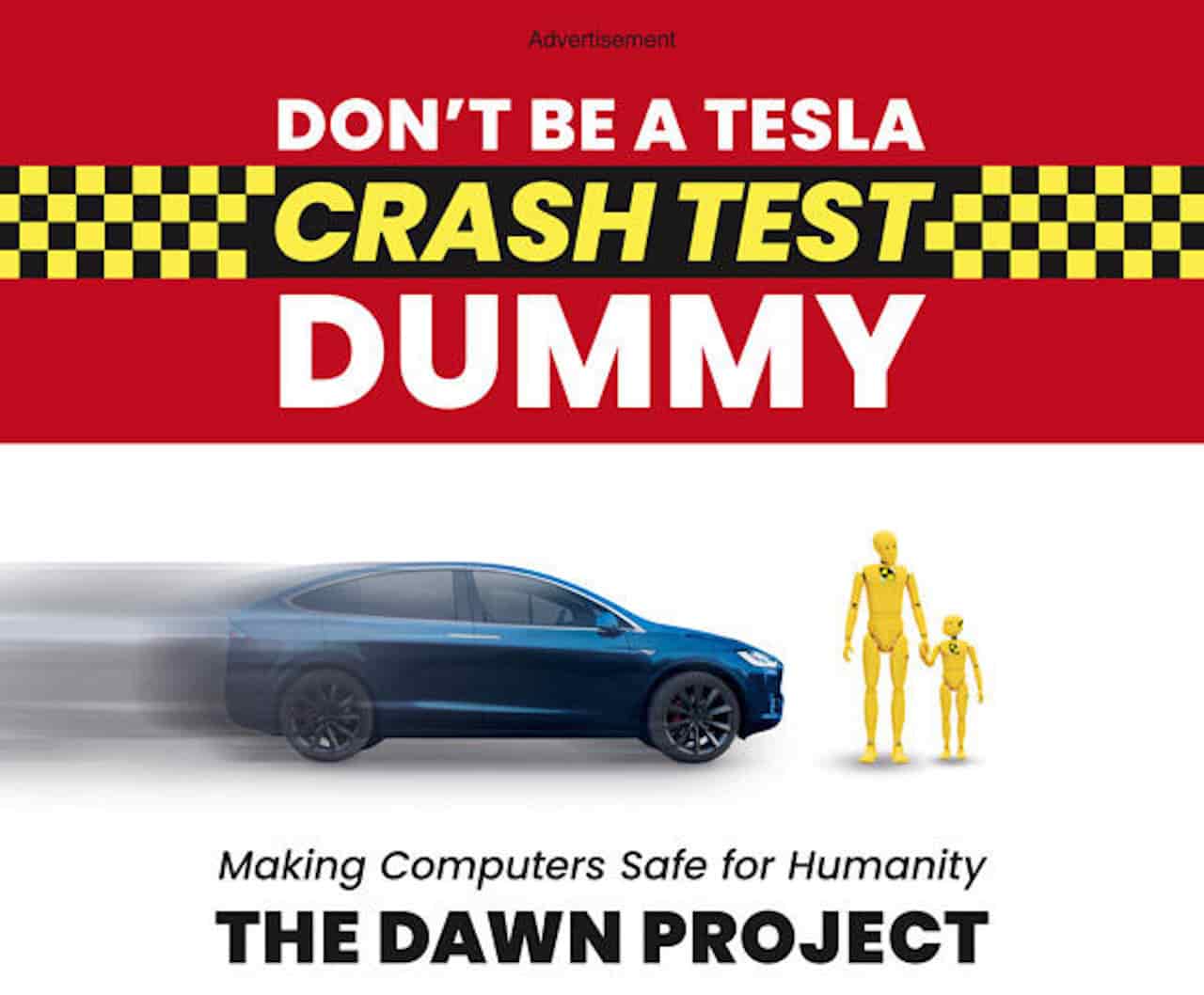

Parte tutto da una “infamata” se così vogliamo volgarmente chiamarla. Sul New York Times è comparsa una pubblicità che ha accusato il software per la guida autonoma (Full Self-Driving) di Tesla, da sempre nel mirino delle critiche per i continui incidenti.

L’immagine è eloquente e la potete trovare qui sotto: “Non essere un manichino da crash test di Tesla“, con il riferimento ai manichini gialli che vengono messi sulle auto durante i crash test e che vedete nell’immagine sulla destra, e che valutano come un veicolo reagisce a un violento impatto.

Nell’immagine raffigurata i due manichini sono una persona adulta e un bambino intendi a camminare come se stessero attraversando una strada, mentre una Tesla sta per colpirlia tutta velocità. L’effetto che vuole fornire l’immagine è chiaro: il software di guida autonoma di Tesla è pericoloso per le persone e causa danni irreparabili.

La pubblicità è stata ideata dall’organizzazione The Dawn Project, che vuole bandire i software di guida autonoma che usa Tesla, e fa parte di una campagna contro il sistema FSD di Tesla. Insomma, non nasconde certo da che parte sta. L’organizzazione chiede, infatti, che venga rimosso dalle strade il sistema di pilota automatico fino a che non registrerà “meno di mille malfunzionamenti critici”.

La valutazione del Dawn Project che chiede la chiusura di Tesla

L’analisi dell’organizzazione è basata sulla valutazione di 21 video pubblicati che potete tranquillamente trovare postati su YouTube, in cui sono presenti modelli di auto Tesla con software di FSD in versione beta 8 e 10. Ciascun video è stato attentamente valutato secondo il sistema della valutazione della prestazione del guidatore del Dipartimento dei Veicoli a Motore (Department of Motor Vehicles o DMV) della California, negli Stati Uniti, e sono stati esclusi tutti quelli con titoli troppo positivi o troppo negativi, in quanto non imparziali per la ricerca.

L’analisi del Dawn Project, che ha valutato i video come se i guidatori stessere eseguendo un esame di patente californiano, ha rilevato che la versione 10 del sistema FSD di Tesla ha registrato ben 16 errori (ti bocciano per molti meno errori) in media in meno di un’ora e un errore di guida classificato come “critico” ogni circa otto minuti. Per errore critico s’intende il mancato rispetto dei semafori e di altri segnali stradali, delle strisce pedonali e l’entrata in contatto con un oggetto o una persona. Insomma, tutto cause di ritiro patente, punti o incidenti.

“I video su YouTube indicano che senza una costante correzione da parte di un essere umano, il sistema Full Self-Driving, nella sua forma attuale, in condizioni meteorologiche ideali, provocherebbe un incidente ogni circa 36 minuti nel traffico urbano” ha sottolineato il Dawn Project.

Tesla non ha tutt’ora commentato la notizia, soprattutto perchè le sue auto ora sono sotto stretto controllo, specie dopo quest’intervento di Dawn Project.